Дневник c00l0ne

-

ПопулярностьТоп-171

-

Постов10,645

-

Просмотров942,936

-

Подписок88

-

Карма автора+681

-

c00l0ne, я ещё никогда так не впахивал как до развития claude code :) Появление LLM

+24

-

Shtirlitz, fastdecision, Feliz, вы не представляете как вам повезло что вы это только здесь читаете,

+20

-

+17

-

Мне однажды сказали примерно следующее: -Не так страшно ,когда человек творит откровенную чушь , куд

+17

-

Просто умножаешь дневной выигрышь на 30, что тут сложного?

+14

-

-

c00l0ne, PT4 база божественна. Тот кто её создал обеспечил меня доходом по многим направлениям. Я буду вечно признателен этим людям за то что они решили не только свою задачу, но и ряд моих :) просто для MDA её использовать также сложно как проехать к бабушке в деревню на мини-купере.

-

Ладно хватит флудить сегодня... Потрещали и ладно

-

90е:

R.I.P.

2026год:

)))

-

ИИ в медицине, рак и устойчивые инфекции можно лечить:

Перевод как обычно не оч, вот оригинал переведенный с помощью gpt:

2-3 месяца обучали:

-

-

rezzo @ 15.01.26

такая фигня получается

Да кто их читает..

Велкоме

обычно работа в качестве прикладного помощника выглядит так :

ПРОБЛЕМА у нас есть такая :

а почему она есть :

как обычно кривые ручки

скидываем файл

и уточняем задачу :

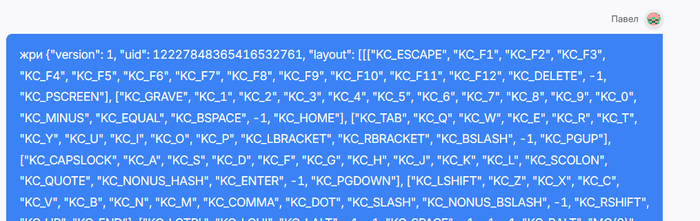

получаем ответ который сложно скопировать из-за кривизны openrouter.ai :

иконка code находиться под обычным копированием почему-то

ладно скопируем "вручную" выделяя мышью фе)

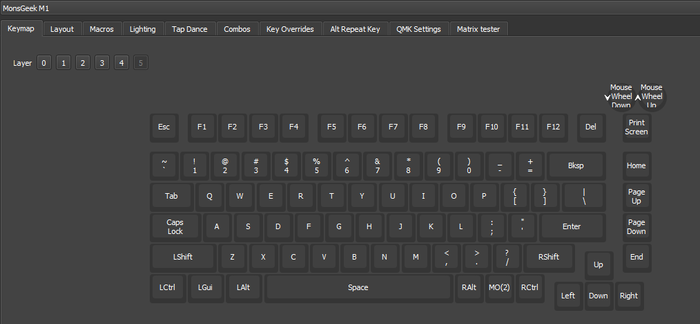

копируем -> вставляем -> сохраняем -> загружаем в vial

и вуалалала раскладки на месте

а что там внутри этого файла это проблемы уже ИИшки имхо)

файл кстати 17 000 символов

Сообщение отредактировал c00l0ne - 15.1.2026, 5:29

Сообщение отредактировал c00l0ne - 15.1.2026, 5:29 -

вот интересная работа :

https://cursor.com/blog/scaling-agents

Это про эксперименты Cursor с долго живущими автономными кодинг‑агентами, которые могут неделями работать над одним большим проектом в сотнях параллельных экземпляров.

Цель (кратко)

Понять, насколько далеко можно масштабировать автономную разработку, если “накинуть больше агентов” на задачи уровня месяцев работы команды, и как их координировать, чтобы они реально продвигали проект, а не мешали друг другу.

Что делали

Сначала пробовали плоскую само‑координацию: все агенты равноправны, договариваются через общий файл задач + локи.

Это ломалось: локи становились бутылочным горлышком, агенты держали/теряли локи, система была хрупкой.

Перешли к optimistic concurrency (без локов, запись не проходит если состояние успело измениться).

Стало надежнее, но возникла другая проблема: без иерархии агенты стали избегать сложных задач, “мельчить” изменения, и прогресс буксовал.

Затем сделали ролевую схему “планировщики + исполнители”:

Planners: исследуют код, формируют задачи, могут порождать под‑планировщиков.

Workers: берут задачу и выполняют от начала до конца, не думая о глобальной координации.

В конце цикла есть judge‑агент, который решает продолжать ли и запускает следующий цикл “с чистого листа”.

Чего добились (результаты)

Смогли запускать сотни агентов параллельно на одном кодbase с минимумом конфликтов.

Примеры:

Браузер с нуля: почти неделя работы, >1,000,000 строк кода в ~1,000 файлах.

Миграция Solid → React в Cursor: >3 недель, правки +266K / -193K, считают, что реально смержить.

Улучшение продукта: автономный агент сделал рендер видео в 25× быстрее (Rust‑реализация), добавил плавный zoom/pan и эффекты — уже смёрджено и пойдет в прод.

Долгоиграющие проекты: Java LSP (550K LoC), Windows 7 emulator (1.2M LoC), “Excel” (1.6M LoC).

Главные выводы

Модель сильно влияет на способность работать долго автономно: пишут, что GPT‑5.2 лучше держит фокус и доводит до конца; разные роли выигрывают от разных моделей.

Система стала лучше, когда убрали лишнюю сложность (например, отдельного “интегратора”).

Самое важное — правильная структура “в меру” и промпты: слишком мало структуры → хаос/дублирование, слишком много → хрупкость.

Если хочешь, могу сделать еще более короткий “в 2–3 предложения” пересказ или выделить только “как устроена архитектура planners/workers/judge”.

Gpt 5.2 оказалась лучшей нейронкой для такой длительной работы

результаты прям вау вау вау

Браузер с нуля: почти неделя работы, >1,000,000 строк кода в ~1,000 файлах.

О.о firefox годами разрабатывался...

Windows 7 emulator (1.2M LoC)

“Excel” (1.6M LoC)

Java LSP (550K LoC)

LoC = lines of code (строк кода)

автономный агент сделал рендер видео в 25× быстрее (Rust‑реализация), добавил плавный zoom/pan и эффекты — уже смёрджено и пойдет в прод

к концу года весь всевозможный софт будет написан агентами имхо

ждем когда windows 12 напишут ) за месяц)

-

знаем роботы всесильны, жаль что роботы не мы )))

-

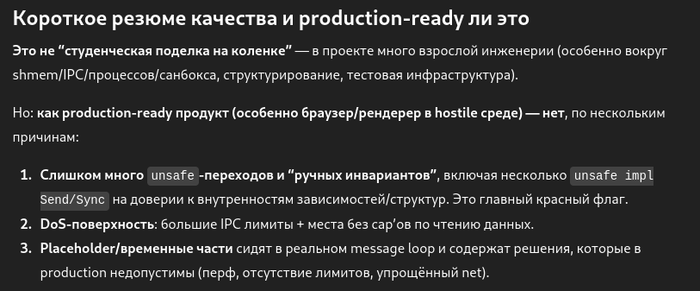

Зашёл перед сном посерфить:

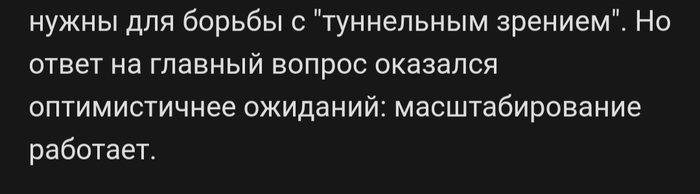

Вот что у них получилось

Промпты важнее, записал

Код выложен тут https://github.com/wilsonzlin/fastrender

Оценка от гптшки

Написанный по вечерам после работы ахаха 3 млн строк в течении что лет?)

6/10 за две недели пойдет с пивом

Через годик до 10/10 дойдут

Я так понимаю цель этого богатого эксперимента это архитектура агентского роя, наладить взаимодействие чтобы никто никого не перекрикивал и выстроить цепочку коллективного оьсуждения, рассуждения...

Сообщение отредактировал c00l0ne - 15.1.2026, 10:20 -

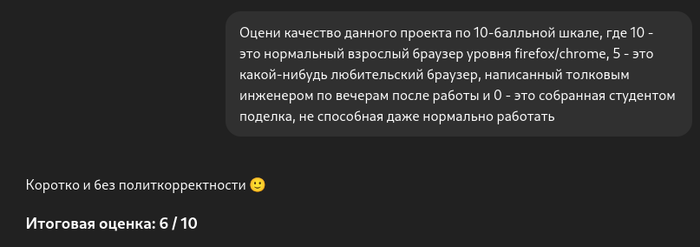

Дорогой дневник , мне не передать ту боль и унижение...

Которое я испытываю когда моя claude code подобная система шлёт дорогие запросы выше контекстного окна > 400k токенов

Собрал тут оркестратор плюс воркеры : пишешь идею проекта, оркестратор разбивает на мелочи , воркеры накидываются мелочевку делать шлют фидбек , оркестратор смотрит насколько они нехорошие шлёт обратно и так по кругу пока они не начнут отправлять запросы выше контекстного окна... Все довольны , кулон без бабла)))

Весело

Разбор полетов:

Придется код смотреть(

В целом ощущаю себя Печкиным

" До чего техника дошла"

Ваши LLM и тут и там показывают...

Сообщение отредактировал c00l0ne - 17.1.2026, 16:19 -

Теоретически как устроено сколько будут стоить ии?) всё привязано к мощностям железа сильно или можно саму нейросеть прокачать, чтобы дешевле использование для всех было?

-

thepazdk, free

Ты не по адресу, я плохой учитель

Кратко берут кластер(много компьютеров) за много миллионов долларов, берут интернет

Вставляют интернет в кластер

В кластере интернет сжимается в сложную архитектуру под названием трансформер

Называют этот трансформер непонятной маркировкой gpt-5.2 , gemini 3.0 или grok 4 или deepseek хорошо не dildocook

Короче называют как нибудь

Теперь после обучения продают небольшими порциями очень голодным потребителям)

Вкратце это узаконенное воровство чужих идей) пока не докажут что llm может генерировать сверх датасета(это так называют интернет на входе)

Недорого стоит

Работает хорошо

Минусы:

Дорого для БОЛЬших проектов

Медленно для БОЛЬших проектов

Нет устойчивой архитектуры для разработки БОЛЬших проектов

Гибкость низкая у существующих агентов

Но я думаю этим минусам недолго осталось

Плюсы :

Смотреть на код не обязательно

Высший уровень ООП

Низкий порог входа

Но такой же порог выхода

Чем квалифицированные входные тем выше качество продукта

Пока что это не lifechanger , но думаю к концу года когда устранят минусы программистам можно официально увольняться с плакатиком "i hate LLM"

Самое угарное что именно на их исходниках LLM тренируются

Не пишите качественный код в паблике

Не загружайте рукописный код в LLM облачные

The end

Как и в покере не выкладывайте качественный контент...

Куда катится мирок...

Сообщение отредактировал c00l0ne - 17.1.2026, 16:50

Сообщение отредактировал c00l0ne - 17.1.2026, 16:50 -

thepazdk, сейчас использование для всех мегадёшего, т.к. крупные инвесторы всё ещё накачивают пузырь AI. Компании вроде OpenAI глубоко убыточны. Я полгода не сверялся с цифрами, но полгода назад это было что-то вроде 4 ярда зарабатывают при расходах 20 ярдов. Не удивлюсь если другие топовые корпорации тоже учавствуют в этой гонке себе в убыток. Сейчас золотое время это всё попробовать, есть неиллюзорный шанс что хайп таких систем угаснет и практическое использование скукошится. Пользовательские LLM для каждого выливаются в запредельные расходы на инфраструктуру и электричество.

Если кому-то захочется запуститься локально, то потребуется нехилый кластер из топовых GPU. И тут ещё проблема, что компании ввалили дохера в R&D и системы обучались далеко не только по публичному коду. Я сам как-то поучаствовал за денежку в тестировании \ исправлении ответов. Но потом потерял возможность т.к. я из неправильной страны. У них там десятки тысяч людей припаханы (индусов в основном).

Из публично-доступного что можно скачать и запустить есть DeepSeek V3.1. Если верить тестам, то она даёт 85-90% от уровня claude code подписки. Но работать будет в разы медленнее. Если набрать б.у.шные NVIDIA A100 (8 штук и сделать ферму), то будет медлее раз в 7. (это где-то 100к надо вложить), Если хочешь на H100 сделать, то будет приемлемо по скорости, но ферма может дойти до 300к по цене (долларов разумеется).

Так что как только пузырь AI схлопнется (ну если мы такой сценарий рассматриваем), то использование такого железа в персональных целях для программирования врядли будет экономически целесообразным. Ну разве что в некоторых задачах. Может марсианская программа сможет такое себе позволить. Не брать же в космос белковых программистов.

Иногда кажется, что каждый новый прогресс будет дешеветь и станет доступным для всех. На деле бывало по-разному в истории. Очередной энергетический кризис и зелёная повестка могут легко ушатать развитие AI. Я бы не ждал, что на дистанции эти инструменты будут дешеветь. Да и собственно не хотел бы этого :)

-

я не так давно начал нейронками интересоваться, более плотно скажем так. из мощного, что на простом железе не пойдет - GLM-4.7 вроде как хорошая. из того, что на своем железе можно запускать - qwen3 в вариациях (qwen3-coder, qwen3:30b-a3b, qwen3:30b-a3b-instruct-2507-q4_K_M, ну я привел имена если из ollama модельки тянуть).

-

SnowBeaver @ 17.01.26

поучаствовал за денежку в тестировании \ исправлении ответов

SnowBeaver,

нормально все бу распределено

Будут фанатики чистого не LLM кодинга, малость крайняя, будут в большинстве своем использующие LLM, и крайне малая часть будет обладать невероятно крутыми агентским системами которые будут писать код уровня ОС windows 11... За три дня...

CashTaker @ 17.01.26

простом железе не пойдет - GLM-4.7

А зачем ? Локально бессмысленно окупать когда на чипах cerebras glm 4.7 летает и стоит копейки...

Ждём deepseek v4 говорят будет лучше текущих sota

-

-

интересны задачи и способы как использовать возможности. Правда в том, что никому нахер не нужен ещё один браузер за 3 дня. даже windows 11 за три часа не нужен. Чтобы бабла заработать надо писать

а вот хер я вам сказал :)

Вот в этом проблема

-

новостей нет ) все отстрелялись вначале года

прогеры все грустные от возможностей ИИ)

но работы реально прибавилось ...

я переделал 5+ микропроектов (по 5 часов каждый)

которые наверное никогда бы не сделал без трансформера и опенсорса...

думаю свет в конце туннеля где-то уже виднеется если продолжать двигаться в этом направлении ...

кодовая база будет только расти ОпенСорса , длина контекста нейронок надеюсь тоже будет расти , чтобы продолжать улучшать эту базу ... и так замкнутый круг и доведем до совершенства исскуство программирования а так же способности трансформера ...

ну ладно про эту скуку

какие получилось закрыть микропроектики

1. макросы на клавиатуру QMK, ну вот есть клавиатура а в ней еще функционал мышки, комбинации макросов записываются только на клавиатуру, но не мышь ) gpt-5.2 с этим был не согласен и успешно (с моей помощью бесконечной ) добавил сей функционал в QMK опенсорс исходники ... пришлось раз 30 перепрошить клавиатуру ...

сообщать бесконечные глюки нейронке , а она потела и все исправляла и пыталась в кбайты памяти внести все мои хотелки ...

но в целом успешно справилась, теперь можно несколько минут записывать клавиатуру + макрос действий и они будут воспроизводиться на железном уровне (usb пакетами) с хорошей точностью, сразу скажу это не для игр), а просто клавиатура крутая хочется фичу активировать ... +exp работы с иишкой

2. проект, просто увидел статью на планировщик проектов, где вы пишите свои идеи по проекту, задачи по проекту, а иишка уже сортирует и делает обзор на день, ставит задачи и контроллирурет их завершение по дедлайнам, все крутиться на Obsidian и плагинах + облако ИИ , решил просто попробовать one shot сделать закинув в ии

опять потрачено несколько было часов, но не понравился проект сам по себе ... но иишка +- функционал весь сделала ...

3. иишка помогла sharex(скриншоты делать ) соединить с телеграммом , делаешь скриншот и отправляешь сразу себе на канал , сделал кстати все пока играл в мтт сессию по холдему, вместо сериалов вайбкодинг даешь) за часик ... pipeline прокинулся, все работает ...

4. сделал скрипты для рабочего компьютера , ограбили у меня фотографа , украли ноутбук недорогой , но на нем был весь софт для работы , скрипты , rip для принтера и т.д. , который я писал н лет назад и уже забыл что как там было сделано

с иишкой за 1 день сделал hot folder , когда закидываешь туда фото и оно сразу печатается на принтере применяется цветокорректирующий профиль для принтера и типа бумаги и т.д.

по кайфу короче

5. попробовал потренировать трансформера для китайского покера ... тут полностью ии занимался , чтобы время не отнимать мое ... ушло 2 дня ... и много денег -50$ ... по факту провально ... ничему не учится ... датасета нет ... да и китайский не сильно уже интересен ...

но попутно написал базу данных для хранения раздач, утилиту для пополнения датасета (где ты сам играешь и сохраняются раздачи в базу данных), потом на базе этих раздач можно потренировать трансформер ... вообщем ии постарался , впечатлило ... но не учится, я не шарю что там не работает , лень разбираться ...

в целом еще по мелочи много чего удалось допилить , но вот самый впечатляющий проект это макрос для клавиатуры, все потому что код в доступе и gpt-5.2 оказался с ним очень хорошо знаком ))) (в датасете был )

что могу сказать после экспериенса работы с ассистентом ИИ( это мой первый такой опыт)

минусы :

1. нестабильная работа с контекстом длинным и к тому же оч медленная , я говорю про 250к+ токенов входящих и выходящих 10-50к токенов ... это в среднем хорошая кодовая база , это хорошая документация , это обработка статей форумов сайтов каталогов таблиц.... мне показалось что есть ошибки при работе с таким контекстом, а так же затупки, где модель перестает быть гибкой , где ей трудно на фоне такого размытого контекста удерживать фокус над поставленной задачей , но в целом троечку с плюсом я поставлю gpt-5.2 (я только с ней работал над таким контекстом ) , может 4- , но до пятерки еще далеко ...

2. стоимость , дорого, один запрос получается выходит от 10 до 50 рублей, а в проекте бывает сотня другая правок, закладывать на них бюджет от 50 $ приходиться ) кажется смешная цифра , а представить что будут тысячи правок и уже по 500 баксов выкидывать на глубокую кодовую базу , чтобы иишка пилила фичи , как будто дороговато уже ...

3. комфорта нету, постоянно приходиться копипастить, claude code страшно запускать на локальном компе, удалит еще чего нибудь , да и контекст расходует не бережно )

вообщем мне проще ручками, а ручками не удобно ...

4. сила ИИ: да это невероятная работа с огромным контекстом , эта штука может прочитать кодовую базу в 10к строк и выдать такую же за несколько минут ... это впечатляет , это вау вау эффект , когда у тебя шевелятся последние волосы на лысине ... но качество ? ! качество за потраченные деньги хорошее, но есть куда стремится ... думаю коллектив людей все еще сделает лучше ...

5. маленький контекст (400к токенов всего ), у быстрых моделей 1 млн токенов , все равно этого мало ...

плюсы :

1. скорость проектирования высокая, но как ассистент достаточно медленный, в автономном режиме конечно имба

2. стоимость проекта низкая, но если проект не делаем с нуля то стоимость поправок высокая

3. качество хорошее, но не top 1% , без опыта в сфере

4. доступность , тут любой может пользоваться

5. опенсорс есть но он пока не такой сильный как закрытые проекты

future:

ждем 10 млн токенов, стабильную работу, хорошее качество и китайские цены ) и чтобы стартера в китай умел))

на сим ухожу плотно в гринд ... увидемся в мтт по холдему) на пд, на покерок приходите катать )

Сообщение отредактировал c00l0ne - 23.1.2026, 23:36 -

А какие сейчас лучшие программы для анализа раздач на предмет количество ошибок в игре? Например, у меня есть база раздач, я хочу понять, как много ев (по спавнению с ГТО) я потерял за все время.

- Вы сможете оставлять комментарии, оценивать посты, участвовать в дискуссиях и повышать свой уровень игры.

- Если вы предпочитаете четырехцветную колоду и хотите отключить анимацию аватаров, эти возможности будут в настройках профиля.

- Вам станут доступны закладки, бекинг и другие удобные инструменты сайта.

- На каждой странице будет видно, где появились новые посты и комментарии.

- Если вы зарегистрированы в покер-румах через GipsyTeam, вы получите статистику рейка, бонусные очки для покупок в магазине, эксклюзивные акции и расширенную поддержку.

SnowBeaver, пришлось загуглить

Да , я дальше базы данных pokertracker 4 не открывал, побаловался в свое время, но она так криво реализована, буэ

Вот думаю такие проекты в этом году и получится реализовать как clickhouse бд покерная