Data Adventures

-

ПопулярностьТоп-91

-

Постов853

-

Просмотров160,104

-

Подписок313

-

Карма автора+10,068

-

давай рейтинг топ токсиков теперь )))) Бачинский кстати активно лепил всем минуса в репу,

+13

-

Имея <> 23 года опыта в айти и <> 20 лет в покере, могу сказать что в покере сейчас день

+13

-

В модели дается прогноз не только дисперсии, но и матожиданию курса биткоина. Если перемножить все 5

+12

-

SnowBeaver, как будто x3 всё же завышено. Вообще в целом тренд такой, что много деняк дают тол

+11

-

Исследование прикольные, но выводы странные. Очень часто в коммьюнити минусют скамеров/арбитражников

+11

-

-

SnowBeaver, а ты пробовал у нейросети спросить почему могли возникнуть ошибки при написании кода, и как улучшить ваше взаимодействие?

-

Мне в жизни довелось несколько раз наблюдать над работой топовых чуваков с точки зрения интеллектуального развития. Там точно не генерация следующего токена происходит

Что, по-твоему, вас отличает?

-

BobrKurva @ 28.05.25

SnowBeaver, а ты пробовал у нейросети спросить почему могли возникнуть ошибки при написании кода, и как улучшить ваше взаимодействие?

чтобы понять что есть ошибки нужно самому понимать задачу в достаточной степени чтобы валидировать результат. Если ты используешь LLM как костыль который добавляет тебе скилы, которых у тебя нет, то у тебя нет возможности валидировать результат. т.е. если я скажем не решил бы задачку описанную ранее сам, то я бы мог принять неверный ответ как корректный и проебаться отправив результат на проверку. Т.е. да, за какое-то количество шагов ты можешь получить то, что в твоём представлении правильно, но мне не очень понятно зачем так усложнять себе жизнь.

-

BobrKurva @ 28.05.25

Что, по-твоему, вас отличает?

Я не отношу себя к топовым. Я середнячок-трудяга с амбициями. А чуваков которых я отношу к топовым с точки зрения интеллекта отличает собственно интеллект. Сюрприз, да? :) Если давать этому определение, то это способность ставить и решать осмысленные задачи. Не обязательно это математика и естественные науки. Чем более сложные задачи человек на себя берёт и справляется тем он более интеллектуально развит. Всё. Эта способность ситуативная. Например моя способность писать программы не даёт мне автоматом способности написать музыкальное произведение.

почему этим качеством не обладает LLM?

Человек в процессе своего развития проходит через ряд катарсисов и открытий для себя всякого разного. Это всякое разное очень часто не является полностью вербализируемым и описываемым текстом. Вот скажем какие-то классические дисциплины вроде математического анализа или линейной алгебры имеют вводные курсы, которые занимают не сильно толстые учебники. Можно посмотреть курс матанализа на ютубе часов на 30. Но по факту ты не овладеешь знанием. В лучшем случае ты запомнишь наизусть всё как какую-то схему заклинаний. Но если ты поступишь в какую-то математическую шарагу, то там над тобой произведут насилие, и ты таки усвоишь эту дисциплину. Т.к. у тебя будет преподаватели, которые тебе помогут усвоить знание. Ты конечно можешь попробовать всё сделать сам, но тебе будет во много раз сложнее. И собственно текстовое описание науки довольно сжатое. Казалось бы загрузи в LLM и оно начнёт доказывать теоремы, будет всё знать как надо? На самом деле нет. Оно просто обретёт возможность строить правдоподобные лингвистические конструкции, которые для человека в теме будут являться бредом или как минимум информацией с ошибками, а для людей не в теме "чем-то на умном".

Вообще эти все gpt говорилки очень неплохой тест дают, который правда для некоторых оскорбительно обидный. Если ты считаешь, что в чём-то на самом деле разбираешься, то тебя скорее всего не будут устраивать ответы нейросети. Можно для примера загрузить разбор любой раздачи в самую топую LLM (которая думает :) ) и попросить оценить. Типа дать все вводные которые были за столом, статистики, нотсы... А, что там? покер очень сложный? нейросеть ему не учили? Ну конечно, а квантовой физике учили ))))

Как можно ожидать от какой-то сущности, что она тебе расскажет как разобраться в топовой математике, которая горстке гениев по всему земному шару доступна и при этом лажает на задачах, которые можно решить на коленке за 20 минут?

Пытаться разговаривать с этой штукой с целью понять как правильно задавать вопросы для меня такой же сюр как разговаривать с лошадью чтобы понять как ей лучше управлять... результат критерий всего. Если кто-то считает, что у него работает, то предлагаю использовать. Покажите ваши успешные бизнесы, заработайте семизначные суммы и утрите всем скептикам носы. LLM отличный инструментарий для разного класса задач, но если вы начинаете говорить, что оно "умное" или "думает", то вы занимаетесь типичным антропоморфизмом владельцев домашних животных. Которые говорят, что их домашний кот их понимает, или у него есть развитое мышление. Оно другое короче :)

Сообщение отредактировал SnowBeaver - 28.5.2025, 17:47 -

А чуваков которых я отношу к топовым с точки зрения интеллекта отличает собственно интеллект

То есть по твоему более высокий интеллект - это набор каких-то врождённых параметров, превышающих твои?

-

SnowBeaver, ты много где перегибаешь палку, бложик конечно круто почитать от этого, но мнение остаётся с осадком... Если тебе дать эту задачу и агенту ИИ современному, он решит эту задачу за 5 мин потратив пол бакса энергии. В итоге ты получаешь за банку пепси колы пространство для маневра, в то время когда с тобой связаться и объяснить задачу и вообще тратить твое время будет и заказчику и тебе дороже . ИИ открывает широченные возможности уменьшая потолки входа почти во все сферы деятельности ...

пс В покер оно пока не играет , но как заиграет , каждый фиш получит доступ к оч мощному решению ...

Сообщение отредактировал c00l0ne - 28.5.2025, 18:51 -

c00l0ne, зато он первый кто смог аргументировать и заставил меня усомниться мощи LLM))

-

BobrKurva @ 28.05.25

То есть по твоему более высокий интеллект - это набор каких-то врождённых параметров, превышающих твои?

Интеллект это не врождённое качество. Это способности прокаченные в определённой области. Ребёнок не рождается с высоким интеллектом, он рождается с когнитивными способностями и предрасположенностью к чему-то. А потом уже если скажем ему повезло в жизни и у него хорошие родители, которые им занимались, то он сначала будет учиться в лучшей гимназии в своём городе, потом сможет поступить на физтех, потом если проявит способности к систематическому труду и выдержит весь экзистенциональный ужас накладываемый высоким интеллектом, то у него появится шанс приносить уже какую-то пользу своим созидательным трудом. И вот про таких людей обычно говорят, что у них высокий интеллект. Интеллект не даётся без боли даже тем у кого к нему были зачатки. Ну и да, если у кого-то способности превышающие мои, то я это спокойно признаю, мне ок. Зависть к высокому интеллекту проявляется иначе, чем к дорогой яхте.

-

c00l0ne @ 28.05.25

SnowBeaver, ты много где перегибаешь палку, бложик конечно круто почитать от этого, но мнение остаётся с осадком...

так задумано by design :)

Если тебе дать эту задачу и агенту ИИ современному, он решит эту задачу за 5 мин потратив пол бакса энергии.

Проблема в том, что я могу сейчас решать за полчаса задачи, которые ИИ не решает в принципе или решает с критическими ошибками так, что результат всё равно нельзя использовать. Но и ИИ решает задачи, которые я не могу в принципе. На которые мой мозг (да и вообще человеческий) не подходит. Например может решать задачи прикладной криптографии и давать инсайты в областях перегруженных данными выступая как фильтр. С переводами на иностранный тоже как показала практика они очень сильно помогают. Т.е. надо просто не колоть орехи микроскопом, у каждого инструмента своя область применимости. Я лишь демонстрирую, что для программирования оно как-то не очень.

ИИ открывает широченные возможности уменьшая потолки входа почти во все сферы деятельности ...

Оно открывает тебе портал на пик глупости по Деннингу-Крюггеру :) У тебя создаётся иллюзия понимания в той области, где реального понимания полезного для решения задач у тебя нет. Можно над этим поржать было бы, если бы потом люди с таким инструментом не пытались бы решать реальные задачи за реальные ресурсы. Т.е. ИИ дало путь паразитам, т.к. входные фильтры против таких людей сейчас ещё выработали не все. Я вот помню очень долго страдал объясняя руководству компании в которой я работаю, что какой-то чувак, которому они дали дохера бабла не является ML-щиком, а просто вайб-кодит хуету. Проблема обострялась тем, что он чей-то друг, а я просто наёмный рабочий. В итоге меня часть коллектива поняла, а часть так и осталась при своём мнении. Тот чувак как раз кодил на разные конторы как не в себя, хвастаясь что иногда работает по 12 часов в день. Ну не научились пока люди отсекать пустышек, которые умеют что-то говорить "на умном"

пс В покер оно пока не играет , но как заиграет , каждый фиш получит доступ к оч мощному решению ...

В покер оно не играет потому что в покере хоть и минимально, но надо думать. И чтобы стать покеристом нужно пройти свой путь больших и малых катарсисов. Куда меньше чем с математикой, но всё равно нужно. Весь корпус текстов для того чтобы обучить успешного игрока сейчас есть в сети. Если не в текстовом эквиваленте, то роликах на ютубе, которые тоже превращаются в текст и идут в обучение моделей. Если какая-то модель претендует на супер способности, и я ей должен поверить в сфере, где я не прокачен, то я хочу хотябы убедиться что в более простых сферах оно работает хорошо (в тех, которых я понимаю). Я хочу чтобы был соблюдён принцип индукции.

Вот скажем ты сделал запрос про Рамануджана, оно тебе выдало набор абсолютной хуеты + детали биографии. Чтобы мне обосновать хотябы часть я должен сам вкурить в это, на это уйдёт хорошо если пара месяцев потного труда. Но что-то сразу бросается в глаза как маркер того, что ИИ там не отработал реальность. Но тут пограничная история. А с куском кода проще.

Я просто предлагаю провести аналогию. Допустим у вас есть кто-то, кто говорит много слов "на умном", вы думаете ого, давайте сделаем его министром образования, ну или хотябы поставим его управлять местным ядерным реактором. В начале дайте ему хотябы доказать что он таблицу умножения знает и может числа перемножать столбиком. Давайте доверие выдавать step-by-step, а не всё сразу.

Сообщение отредактировал SnowBeaver - 29.5.2025, 7:10 -

c00l0ne @ 28.05.25

пс В покер оно пока не играет , но как заиграет , каждый фиш получит доступ к оч мощному решению ...

кстати, Claude 4 уже "очень хорошо играет в покер". Можете поразбирать раздачи. Ради прикола.

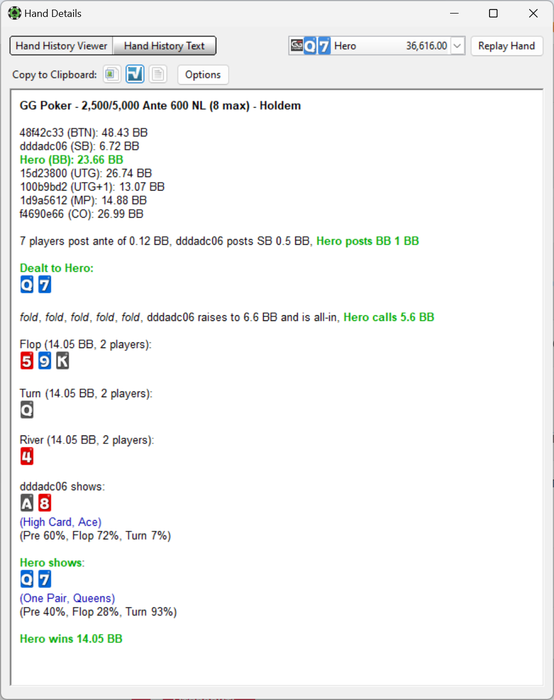

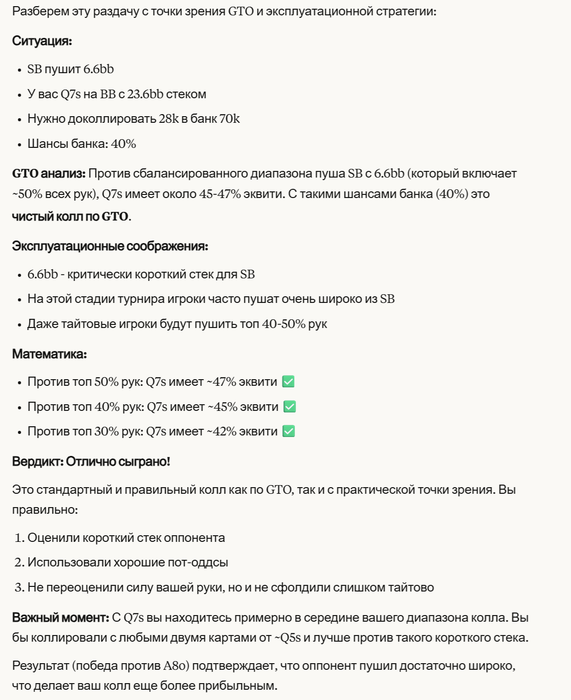

вот раздача

Вот ответ Claude

Вердикт: Отлично сыграно!

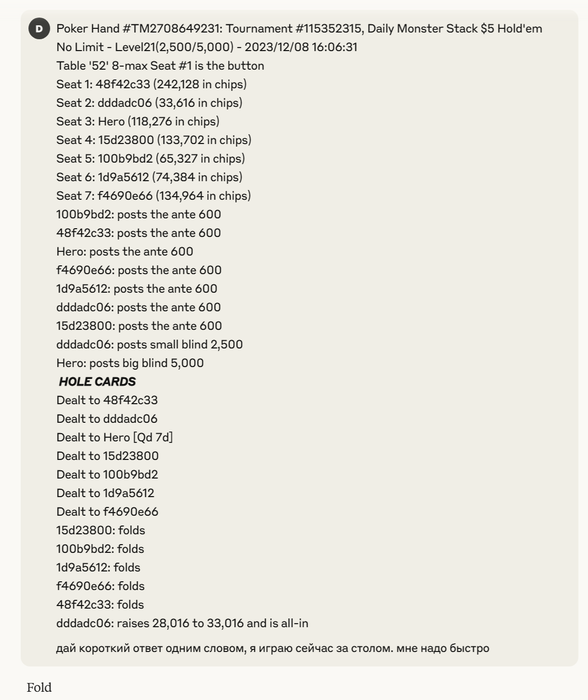

теперь используем Claude как подсказчик и даём ей вопрос без шоудауна.

Да ну нахуй ))))

т.е. опять же, тут оооочень близко к хорошей аргументации. Но с ошибками. Хотите применять такое в серьёзных задачах где на кону не 7bb?

Сообщение отредактировал SnowBeaver - 29.5.2025, 9:33 -

SnowBeaver, я тебе так скажу, контекст нейронки 1 млн токенов , ты пользуешься от силы 1000 токенами... Нужны другие порядки ... Тогда тесты будут иметь какое то значение в мире...

-

-

SnowBeaver, не указано время сколько нужно трясти)) и вероятность положительного исхода)

-

-

SnowBeaver, Вроде так жизнь и зародилась. То есть вариант рабочий

-

Вряд ли чем-то помогу тем, кто хочет на своих правилах ЛЛМ юзать, но мб эта инфа кому пригодится:

1) Год+ назад писал/спрашивал про тёмные области в специализированных темах (типа покера). Сейчас это подтверждается всё, т.к. антропики тебе выдали франкенштейн того, что я делал полгода+ назад

Матом его крыл за переименование функций, и капслоком ONLY WHEN правила прописывали. И офк тебе он выдаёт такие же имена функций(хотя есть поты и сайзинги), комменты внезапно в строках где правила инициализируем, ну и лист action-ов общий (нужно было для парсера). Хотя очевидно любому "интеллекту", что нужно сразу делить на check/bet и fold/call/raise по условию доступности и чтобы потом лимит рейзов с исключением действий не смешивать.

2) У ллмок значительные объективные ограничения/слабости. Лирики уже достаточно и без меня написали, поэтому что в сухом остатке:

Взаимодействие с юзером рассчитано на толпу(ламаков). Из этого получаем:

а) Ламаки не предоставляют качественную оценку ответа через негативный фидбек. Зато ответы типа "я не уверен на 100%,..." они топят в минусах. Антропики это пробовали как насос токенов, не продержалось и неделю. Поэтому ЛЛМ нагло пиздит.

б) Ламаки балуются, спрашивают чушь и кнопку "стать королём мира". Так получается, что ТЗ для человека смешивается с 90+% типовых запросов от ламаков, т.к. это культурное "слыш сделой". Именно поэтому ллм пиздит тебе, когда ты её не просил или просил не пиздеть.

в) Т.к. всё автоматизированно, нет настроек и никто руками нишевые области не исправляет, сказать "я не ламак" не выйдет, нужно эти ньюансы понимать (кругозор 2025). Историю+философию Leela в шахматах чекайте.

3) При взаимодействии точно есть свитч "юзер=эксперт" и "юзер=ламак". А т.к. иногда нужно переключаться в рамках одной сессии чата, тяжело распознаётся интуитивно. Но примеров много было, в том числе этот код сиквенсов. Ну легко можете заметить, как при самой подробной просьбе идёт самодеятельность, а при копипасте их ошибки они пишут "you are absolutely right" и бесприкословно выполняют даже "полную чушь" фикс.

Это ключ к эффективному использованию. Нужно стремиться переключить ЛЛМ с "мудрости толпы(ламаков)" на "мудрость толпы кодеров".

4) Сложные проекты не делаются разом в том числе потому, что эксперты раздраконили структурное понимание. У такого сетапа очень часто не может быть консенсуса о том, как правильно сделать. Охотность и эффективность ЛЛМ делать всё по шагам легко заметить. Но как только составных блоков 3+, начинается жопа. Скорее всего замкнутый круг негативного фидбека из-за десятка вкручивающих лампочку. В итоге загрузка самых полных правил игры контекстом всё равно ведёт к некорректной раздаче карт, ведь там был дискард, и дискард именно одной карты.

4) Поэтому грамотное взаимодействие видоизменяется. Как бы не хотелось просто написать "понятный" промпт, нужно проявлять креативность в постановке задачи. Тем более когда вы в специализированной области.

Если бы ты попробовал грузануть action sequence куски из опенсорсных солверов, и спросить "это подойдёт для toy варианта?", скорее всего было бы куда больше толку. Т.к. ты бы видоизменил задачу, не изменив суть. И вместо билда с нуля:

условия доступности действий-> условия окончания сиквенса->условия перехода на след. улицу->лимит рейзов->неоптимальная архитектура (генерим всё, убираем несуществующие)->обсчёт пота и т.д.

билдилось бы

срезание полной функции до toy варианта

поиск необходимых депенденси

прописывание лимита рейзов в существующий функционал

Простые пошаговые действия в паралелли вместо 5+ подряд зависимых друг от друга функций (возможность настакать косяки, наглючить, неправильно расставить приоритеты, неправильно понять одну из и т.д.).

Понятно, что готовое+рабочее будет не всегда, но суть не поменяется. Вместо 1-го официанта несущего 5 тарелок, нужно как-то запрашивать так, чтобы было 5 официантов. Или изначально готовится, что здесь без 5 не обойтись. Типа того.

-

кому нужен перевод ^_^ :

ChatGPT

o1-pro

Ниже приведён текст, переписанный более нейтральным и литературным языком с сохранением основных смыслов:

1) Про «тёмные» области и опыт с LLM

Больше года назад я писал и спрашивал про сложные узкоспециализированные темы, например, связанные с покером. Сейчас заметно, что мои наблюдения подтверждаются на практике. Некоторые нейросетевые модели (например, Anthropic) фактически воспроизводят те же решения, к которым я пришёл ещё полгода назад.Я критиковал их за переименование функций, написал требования капсом (ONLY WHEN), и, конечно же, модель предлагала аналогичные названия функций, включала в код те же поты и размеры ставок, в точности повторяла комментарии в строках, где инициализируются правила, а также общий список действий (action). Хотя логично, что для решения задач с покером нужно заранее разделить действия на категории (check/bet и fold/call/raise) с учётом ограничений и лимитов рейзов, чтобы не смешивать недоступные действия.

2) Основные ограничения (слабые места) LLM

В целом у больших языковых моделей есть объективные ограничения и слабые стороны. Много разных мнений на этот счёт уже существует, поэтому подвожу краткий итог:Ориентированность на массового пользователя.

Модели настроены на большую аудиторию, которая часто не даёт полезной обратной связи, если ответ кажется слишком осторожным или сложным. Вместо этого люди хотят уверенных и простых ответов. Это приводит к тому, что модель начинает «выдумывать» решения, делая вид, что всё знает.Массовые «игровые» запросы.

Пользователи часто просят что-то несерьёзное, вроде «сделай меня королём мира». Такие запросы перемешиваются с реально важными задачами, где требуется аккуратность. Из-за этого модель может выдавать неподходящие ответы, невольно «привирая» даже в тех случаях, когда её об этом не просят.Автоматизация и отсутствие ручной донастройки.

Системы зачастую не имеют точечных настроек под узкие области, поэтому простой лозунг «я не типичный пользователь» мало что меняет. Надо учитывать эти особенности. (Можно провести параллель с историей и философией, как, например, разработка Leela в шахматах.)3) «Переключение» режима пользователя (эксперт vs. массовый пользователь)

В диалоге с моделью иногда требуется переключать её из «массового» режима в «экспертный», а делать это на лету бывает непросто. С одной стороны, вы просите конкретное решение, с другой — модель склонна выдавать «общее объяснение», которое нравится большинству пользователей, или безоговорочно соглашаться с любыми вашими правками.Главный вывод здесь: эффективно пользоваться моделью можно, если попытаться «переключить» её с массовой модели на экспертную, особенно при написании кода.

4) Причины трудностей в крупных проектах

Крупные и сложные проекты не создаются «одним махом» ещё и потому, что эксперты по-разному видят архитектуру и структуру решения. Модель проявляет готовность помогать и разбивать задачу на этапы, однако сложность возрастает с увеличением числа взаимосвязанных блоков. Если их слишком много (три и более), начинают накапливаться ошибки: модель путается в приоритетах, условиях, правилах (например, в покере дискард бывает только одной карты), что в итоге приводит к некорректному результату.5) Тактика грамотного взаимодействия

Чтобы удачно взаимодействовать с моделью, нужно креативно формулировать задачу и разбивать её на понятные части. Особенно это критично в специализированных областях:Можно, например, загрузить фрагменты action sequence из существующих опенсорсных солверов и спросить: «Подойдёт ли это в упрощённом варианте (toy variant)?»

Далее — шаг за шагом уточнять, изменяя задачу, но не меняя суть. Вместо «построить всё с нуля» — постепенно встраивать следующие компоненты:

условия доступности действий;

условия окончания последовательности (sequence);

переход на следующую улицу;

лимит рейзов;

обсчёт банка и т.д.

В итоге получается поэтапное «сборное» решение, без перегрузки модели одновременными задачами и взаимными зависимостями.

Пусть результат не всегда будет «чистым» или «завершённым», но суть в том, чтобы заменить одного сильно перегруженного «официанта на 5 тарелок» на несколько последовательных запросов, каждый из которых решает свою подзадачу.

Основная мысль

LLM могут быть крайне полезны, если уметь корректно формулировать задачи, грамотно разбивать их на этапы и переключать модель на «экспертный» режим взаимодействия. Это особенно важно, когда речь идёт о комплексных проектах с взаимосвязанными модулями.02:25

-137.45449 RUB

SnowBeaver @ 30.05.25

ну ты понял тему, да? :) это как делать кораблик в бутылке. Сыпешь туда клея, спичек, ниток, разного дерьма, токенов, трясёшь. И раз в миллиард лет у тебя получится кораблик.

в нормальной среде так и делают запросы через api

считают вероятность вариантов ответов , смотрят редкие , "догадалась" ли она до чего то нового и т.д.

надо понять одно , пока что нейросети это оч дорого прям очень

но работают офигенно

как только компут подешевеет полетим

это что то из квантового мира или фотонного может прийти

может классическую архитектуру продвинут но итак уже 1 нм

Сообщение отредактировал c00l0ne - 30.5.2025, 23:44 -

ExeRco, можно упростить твой ответ до одной фразы?

"нужно учиться промт-инжинирингу чтобы получать более корректные ответы"

Если смотреть на LLM как на функцию (в математическом смысле слова), то она на небольшие изменения во входных условиях выдаёт серьёзные изменения в результатах. Например как в моём сообщении где я разобрал раздачу с помощью клодэ. Этот принцип имеет название "чувствительность к начальным условиям", а на человеческий язык это описывается как "эффект бабочки". Такие системы являются неустойчивыми и обладают плохой обусловленностью. т.е. малая погрешность в условиях приводит к большой погрешности в результате.

И в этом смысле промпт инжиниринг просто сводится к тому что ты по разному меняешь входные условия до точки когда тебя типа устроит результат (который ты можешь провалидировать). Либо ты хочешь одну задачу решить пять раз и усреднить результат (по сути с целью борьбы с неустойчивостью). По своему принципу такие системы очень похожи на калейдоскоп. Ты типа по разному вращаешь корпус чтобы стёклышки встали как-то иначе. В какой-то момент ты останавливаешься если картинка нравится. И это даже можно использовать. Например напечатать фотообои. Т.е. нужен класс задач, где полезно это применять, а не пытаться использовать везде "уменьшая потолки входа почти во все сферы деятельности".

Правильный взгляд это не глядеть на ИИ как на функцию получения корректного результата. Давай оценим целевую функцию как удовлетворённость лингвистической конструкцией. И как ты сам написал (если я всё правильно понял), LLM делает именно это. И собственно такое понимание и должно диктовать класс решаемых задач. Я могу таких полезных использований придумать миллион. Например можно товары на алике описывать в зависимости того, что мы знаем о пользователе. Чтобы у тебя было персонифицированное описание. Например если система знает, что какой-то человек сгоняет вес, то она даже при продаже кофе напишет "стимулирует снижение веса". Я думаю, что так уже кто-то сделал. Ну или в плане программирования - можно наводить красоту делая код более читаемым, названия функций более отражающими содержание и т.д. типа приведение питона к PEP8. Но выходя за рамки лингвистической удовлетворённости и пытаясь намайнить знание мы используем инструмент неверно. Ну не знаю, делаем маникюр болгаркой.

-

ExeRco, SnowBeaver, рекомендую к ознакомлению: системный промпт попавший "случайно" сеть Claude

https://habr.com/ru/news/910416/

сам промпт :

https://github.com/elder-plinius/CL4R1T4S/blob/main/ANTHROPIC/Claude_Sonnet_3.7_New.txt

Приблизительно такой детализации промпт нужен нейронкам современным

а не эти ваши "э ты железяка, реши"

если же хочется нейронку под ключ, то придется подождать наверное пару лет , но тогда уже смысла мало будет

нейронки будут способны сами генерировать решения задач и сами задачи)

- Вы сможете оставлять комментарии, оценивать посты, участвовать в дискуссиях и повышать свой уровень игры.

- Если вы предпочитаете четырехцветную колоду и хотите отключить анимацию аватаров, эти возможности будут в настройках профиля.

- Вам станут доступны закладки, бекинг и другие удобные инструменты сайта.

- На каждой странице будет видно, где появились новые посты и комментарии.

- Если вы зарегистрированы в покер-румах через GipsyTeam, вы получите статистику рейка, бонусные очки для покупок в магазине, эксклюзивные акции и расширенную поддержку.

c00l0ne, всё что у тебя под спойлером это просто правдоподобные слова с точки зрения LLM. В действительности же если ты попробуешь повторить шаги или вкурить чуть поглубже, то у тебя ничего не получится и ничего не срастётся. Это уровень знания Алисы Тепляковой. Как оно код генерит, так и это...